Verdens første regulering av kunstig intelligens

Etter innføringen av GDPR satt EU seg i førersetet for regulering av digitale rettigheter knyttet til personopplysningen. Nå kommer en ny forordning som tar sikte på å gjøre det samme innen bruk av kunstig intelligens.

3 min read

·

By Mats Knutsen-Valen

·

December 20, 2023

Fredag 8.desember tok EU ett nytt viktig steg i prosessen med å formelt vedta den etter hvert mye diskuterte EU Artificial Intelligence Act, gjerne omtalt som EU AI Act.

Forordningen ble påbegynt allerede i 2021, i god tid før verden for alvor fikk øynene opp for AI/LLM, og tar mål om å innføre en rekke regler som vil ivareta borgernes rettigheter og verdier i møtet med en stadig økende bruk av kunstig intelligens. Ikke ulikt hvordan EU sørget for innføringen av GDPR, men da med bruken av personopplysninger.

Man kan trygt si at 2023 har vært banebrytende med tanke på å bringe kunstig intelligens fra forskningsmiljøene og inn i et hvert styrerom og ledergruppe i omtrent hele verden. Fra å være noe alle kjente til, men ikke selv benyttet, har banebrytende løsninger som ChatGPT, DALL-E, Midjourney og nå senest Gemini fra Google, banet veien for at kunstig intelligens nå er på alles lepper.

Med denne enorme fremveksten av kunstig intelligens er det lett å se for seg scenarier eller bruksområder hvor løsningene kan brukes til å skape uante, eller bevisste, løsninger som ikke hensyntar våre verdier eller rettigheter.

Hva innebærer den nye forordningen?

Denne artikkelen går ikke i dybden på hele forordningen, men i likhet med GDPR vil også den nye forordningen innføre strenge bøter dersom man bryter reglene, og det legges opp til flere nye krav til dokumentering og rapportering. Et sentralt punkt er risikovurdering og klassifisering av den enkelte tjeneste eller løsning.

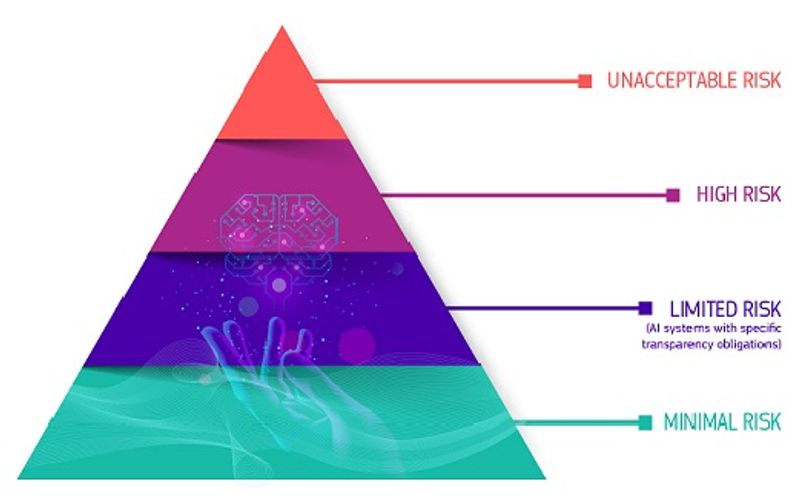

Avhengig av hvor stor risiko bruken utgjør vil man måtte oppfylle en rekke krav innenfor fire ulike nivåer definert av EU, som vist i figuren under.

Nedenfor forklares nivåene kort, men det anbefales å lese gjennom EUs egne eksempler og tekst for utfyllende eksempler og forklaring. Teksten er enn så lenge kun på engelsk.

Uakseptabel risiko

Slike systemer vil ikke være tillatt under den nye forordningen. Ett eksempel EU selv trekker frem her er sosial scoring av innbyggere fra deres egne myndigheter eller leker med stemmeassistanse som oppmuntrer til farlig oppførsel

Høy risiko

Dette kan være løsninger som blant annet omfatter kritisk infrastruktur (transport), AI for CV-sortering, kredittscoring for å innvilge lån etc (se EUs egen liste for utfyllende eksempler). Løsninger definert med høy risiko vil være underlagt strenge forpliktelser før de kan selges eller brukes i markedet.

Eksempler er:

- Tilstrekkelige risikovurderinger

- Høy kvalitet på datasettene som benyttes

- Logging for å skape sporbarhet i avgjørelser

- Detaljert dokumentasjon

Begrenset risiko

Applikasjoner og løsninger med begrenset risiko vil måtte informere om dette slik at man som bruker selv vet at man interagerer med kunstig intelligens. Ett åpenbart eksempel her er chatbots

Minimal risiko

Forordningen legger opp til fri bruk av løsninger som defineres innen denne kategorien, eksempelet som trekkes frem her er spam filtre med kunstig intelligens. Som EU skriver selv «The vast majority of AI systems currently used in the EU fall into this category.»

Hva skjer videre?

Digitaliseringsdirektoratet skriver at det enda er uklart når forordningen vil vedtas, men straks den vedtas vil den bli gjeldende for EU-land to år etter vedtakstidspunktet.

Selv om det potensielt er en stund til forordningen trer i kraft bør selskaper og organisasjoner som benytter seg av kunstig intelligens allerede nå starte kartleggingen av de nye reglene.

Som ved andre av EUs nye regelverk har det vært heftig debatt mellom flere av EUs medlemsland underveis og det blir spennende å følge forordningen videre.